Una política, el azar, unos datos y finalmente los hechos

Por: Marcelo Perera*

Para analizar la eficacia de un medicamento, la investigación médica compara el resultado de un grupo de tratamiento (al que se le aplica dicho medicamento) con el de un grupo de control (al que no se le administra o se le aplica un placebo). Una condición fundamental es que ambos grupos sean similares y una manera de lograrlo es que cada persona sea asignada al azar a uno u otro grupo. Este es el método que las ciencias experimentales utilizan para validar sus conclusiones y conocer relaciones de causa y efecto.

¿Qué ocurre cuando en lugar de un medicamento nos interesa analizar la eficacia de una política pública? En este caso, a pesar de los potenciales efectos que la política puede tener en el bienestar de las personas, es más habitual que los encargados de diseñarlas actúen a ciegas, en base a presentimientos e intuiciones y en el mejor de los casos confrontando puntos de vista en base a cifras más o menos pertinentes. Afortunadamente esta realidad está cambiando y cada vez más, es posible la discusión y formulación de políticas públicas basadas en la evidencia.

Desde hace algunas décadas, el análisis económico ha experimentado una renovación metodológica y se ha visto enriquecido por el uso de métodos empíricos equivalentes a los de las ciencias experimentales. Naturalmente, no siempre podemos recurrir a estudios experimentales (por razones éticas o de costos, entre otras). Sin embargo, un buen punto de partida es hacer un mejor uso de la información disponible, como el empleo oportuno de bases de registros administrativos con las que, dado el diseño del programa, podamos emular el análisis experimental.

Esto último se ve facilitado si por la vía de los hechos la participación o no participación de una persona en un programa público, dentro de un colectivo de potenciales beneficiarios, es producto del azar (¡igual que en un experimento!). Si luego de implementada la política logramos obtener información que mida algún resultado de estas personas, la diferencia en el resultado medio entre ambos grupos (tratamiento y control) es una muy buena medida del impacto del programa[i].

Veamos el ejemplo de una política de inclusión sociolaboral en Uruguay, el programa Uruguay Trabaja del MIDES. Este programa apoya la inserción laboral de personas que han estado desocupadas durante un largo tiempo (dos años), con bajo nivel educativo y que pertenecen hogares en situación de vulnerabilidad socioeconómica. Los beneficiarios desempeñan trabajos comunitarios durante un máximo de ocho meses (en general en obras de mantenimiento de edificios públicos), reciben apoyo formativo en competencias transversales a través de talleres y reciben un subsidio económico.

Dado que cada año el número de inscriptos supera ampliamente el número de cupos que ofrece el programa (unos 3000), la asignación de los mismos se realiza mediante un sorteo público. Tenemos entonces los grupos de tratamiento y control elegidos al azar ¿Qué falta para tener una evaluación de impacto del programa? Necesitamos información de seguimiento tanto de los participantes como de los inscriptos no participantes para compararlos en algún resultado relevante. Una posibilidad es recurrir a registros del BPS y conocer si estas personas, luego de finalizado el programa, tuvieron un empleo formal.

Esto es lo que se analizó en un reciente estudio (Nogueira, 2018[ii]). Se utilizó una base de datos anonimizada (protegiendo la identidad y datos de las personas) construida por el MIDES en base a registros de postulantes a la edición 2011 y a información aportada por BPS. Esta información permite evaluar el impacto de la edición 2011 de Uruguay Trabaja en la empleabilidad en el sector formal dentro del año posterior a la finalización del programa. Si bien el análisis se ve limitado por el corto espacio de tiempo en el que se observan los resultados (y por la imposibilidad de medir otras dimensiones relevantes), los resultados son muy interesantes.

Considerando el promedio de los participantes, se observa que el programa no aumenta la probabilidad de empleo formal dentro del año posterior al egreso. Es más, el programa disminuye ligeramente dicha probabilidad en aproximadamente 2 puntos porcentuales (p.p). Una posible explicación de este efecto medio negativo es el llamado efecto de bloqueo (lock-in) que es esperable produzca este tipo de programas a corto plazo. En los meses posteriores al egreso un participante promedio presenta una menor inserción laboral, de la que hubiera tenido de no haber participado en el programa, por el hecho de haber dedicado menos tiempo a la búsqueda de empleo debido a la ocupación en las actividades del programa y al menor incentivo generado por el subsidio. Es esperable que este efecto se reduzca un tiempo después, cuando los beneficiarios estén buscando trabajo activamente (aunque esto no pudo ser analizado en el citado estudio).

Pero los resultados más interesantes aparecen al analizar los impactos en grupos específicos. Concretamente, el impacto negativo es especialmente alto entre los hombres (-8 p.p.) y es nulo en el promedio de las mujeres. Sin embargo, la característica que más condiciona el impacto del programa es la experiencia previa en el sector formal (considerando los seis años previos a la inscripción en el programa). Para los que no tienen experiencia el impacto del programa es positivo (2 p.p.) y para los que tienen experiencia formal el programa impacta negativamente en la empleabilidad (-10 p.p.).

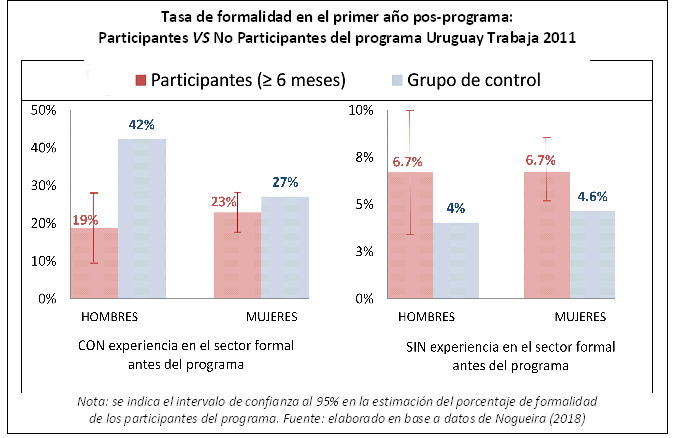

Finalmente, si se analizan por separado los hombres y las mujeres según tengan o no experiencia formal, se encuentran efectos estadísticamente significativos y de signo contrario en dos grupos (ver Gráfico). El programa tiene un impacto positivo y significativo entre las mujeres sin experiencia, aumentando de 4.6% a 6.7% la probabilidad de empleo formal. Por otro lado, tiene un alto impacto negativo entre los hombres con experiencia de cotización, disminuyendo desde 42% a 19% la probabilidad de tener un empleo formal en el año siguiente al egreso del programa.

Esta enorme heterogeneidad de los impactos sugiere que el programa Uruguay Trabaja (en su formato actual) podría mejorar su efectividad priorizando los solicitantes con peores perspectivas de inserción laboral, fundamentalmente personas sin experiencia formal. Alternativamente, podría atenuarse el efecto negativo en la empleabilidad de quienes en principio tienen mejores perspectivas laborales (especialmente los hombres con experiencia formal), acortando el período de tareas operativas, o comenzando sólo con una asistencia a la búsqueda de empleo y luego la capacitación, o aplicando el programa en secuencias interrumpidas por períodos de búsqueda de empleo y con reinscripción condicionada a no haber encontrado empleo en cierto período.

Este es sólo un ejemplo de cómo podemos aprovechar la información disponible para comprender si un programa funciona o no, o si sólo funciona para unos grupos y no tanto para otros. Es un ejemplo de cómo evaluar para constatar los hechos en base a los cuales debatir el diseño de las políticas públicas.

[i] Al igual que en la investigación médica, es indispensable velar por el cumplimiento de los principios éticos que rigen la investigación con seres humanos.

[ii] Nogueira, Rosina (2018) “Las Políticas Activas del Mercado de Trabajo: revisión de las experiencias de evaluación y una estimación del impacto del Programa Uruguay Trabaja”, trabajo monográfico para obtener el título de Magíster en Economía, FCEA-UdelaR.

* Investigador de CINVE. Doctor en Economía por la Universidad de Alcalá (España). Profesor de la Universidad de la República y de la Universidad ORT (correo: [email protected])